GPT-4o発表!OpenAI Spring Updateの発表内容まとめ

5月14日午前2時(日本時間)から、OpenAIは「Spring Update」と題し、GPT-4関連の新機能についてのライブ配信を実施しました。この記事では、OpenAIがライブ配信で発表したSpring Updateの内容についてまとめます。

今回の発表の目玉は、新しいフラッグシップモデルであるGPT-4oの登場です。GPT-4oは、従来のGPT-4よりも高速で、テキスト、視覚、音声の一括処理が可能となっています。また、無料ユーザーにも提供されます。

なお、ライブ配信のアーカイブはこちらのYouTubeから確認できます。

デスクトップ版ChatGPTの提供開始とUIの刷新

イベントで最初に触れられたのは、デスクトップ版ChatGPTのリリースです。これにより、ユーザーはモバイルデバイスだけでなく、デスクトップでも同様に気軽にChatGPTを利用できるようになります。これについて、OpenAIのCTOであるMira Murati氏は、「フリクションを減少させ、誰もがChatGPTを使えるようにすることが重要だ」と強調しました。

ChatGPTのmacOS版デスクトップアプリは、本日より有料のChatGPT Plusユーザー向けに提供され、今後数週間でさらに多くのユーザーに提供される予定です。また、今年後半にはWindows版も提供される予定です。

新しいデスクトップ版リリースと同時に、UI(ユーザーインターフェース)の刷新も発表されました。今までより直感的に操作でき、ChatGPTとのやり取りに集中できるように工夫されています。Murati氏は「モデルが複雑になる一方で、操作体験はより自然で簡単になる」と説明しました。

GPT-4o

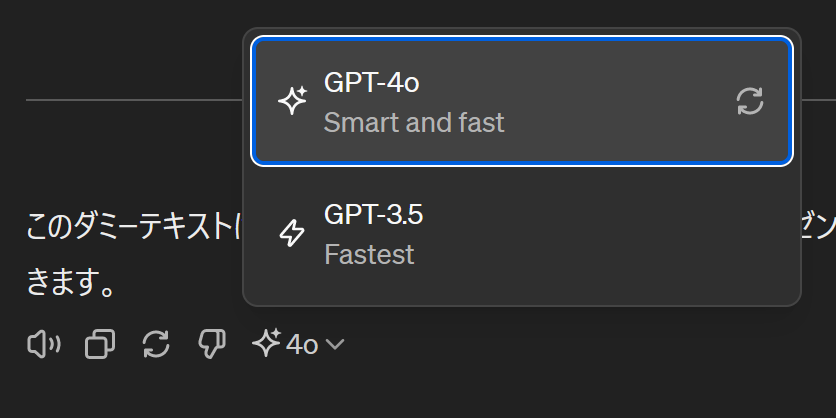

今回の発表のハイライトは、OpenAIの新しいフラッグシップモデルであるGPT-4o(GPT-4 Omnimodel) です。GPT-4レベルの性能でありながら、パフォーマンスが大幅に向上しています。GPT-4oはGPT-4 Turboよりも2倍高速で、価格は半分になっています。本日からChatGPTの無料プランと有料プランのユーザーに展開されています。

Voice Modeについても大きな進化が見られました。従来の音声モードとは異なり、リアルタイムでの対話が可能となり、ユーザーは音声での会話中にモデルの発話を遮って話しかけることもできます。さらに、GPT-4oが組み込まれたChatGPTは、対話の感情を理解し、会話のトーンに応じて声のトーンを変える機能も搭載されています。

こちらのデモ動画では、GPT-4oの感情豊かな音声を聞くことができます。

GPT-4oは、ChatGPTの無料ユーザーにも提供されます。また、GPT-4oはテキストだけでなく、画像や音声も同時に処理できるマルチモーダルモデルです。これにより、ChatGPTを使って、テキスト、画像、音声のすべてを同時に扱えるようになります。GPT-4oのAPIは、本日から利用可能で、音声とビデオを近日中にサポートするとのことです。

GPT-4oの詳細については、こちらの記事で詳しく解説しています。

OpenAIのWilliam Fedus氏は、GPT-4oがLMSys Arenaで「im-also-a-good-gpt2-chatbot」という名前でテストされていたことを 明かしています 。im-also-a-good-gpt2-chatbotは、突如現れたGPT-4レベルの高性能LLM「gpt2-chatbot」が使えなくなったあとに代わりに登場したモデルです。その性能や エラーメッセージ から、OpenAIの次世代モデルではないかとうわさされていました。OpenAIのCEOのSam Altman氏は自身のX(旧Twitter)で、GPT-4oについて「非常によいモデルです(テスト中に名前を少し楽しんでいました)」と 述べています 。

新機能のデモ

イベントでは、新しいGPT-4oを組み込んだChatGPTのさまざまなデモが実施されました。

音声モードのデモでは、OpenAIのフロンティア研究責任者のMark Chen氏がスマホを使用してリアルタイムの対話を実演しました。ライブステージ上で「深呼吸をするアドバイス」を求められたChatGPTは、ジョーク交じりに応答しました。歌を歌ったり、感情豊かな声で話すことも可能なようです。

視覚機能についても、OpenAIのポストトレーニングチームを率いるBarrett Zoph氏が紙に書いた方程式をChatGPTに解かせるデモを行いました。スクリーンショットや写真などをアップロードし、ChatGPTと視覚的に対話できるとのことです。

さらに、Chen氏はプログラミングコードのデバッグのデモを実施しました。ChatGPTがコードの内容を理解し、適切なアドバイスを提供することで、プログラマーの作業効率を大幅に向上させます。

最後に、リアルタイムでの翻訳機能と感情推定のデモが行われました。イタリア語を英語に翻訳するタスクや、カメラから取得したユーザーの表情から感情を読み取る機能が紹介され、会場から大きな拍手を浴びました。会話のラグはほとんどなく、また割り込んで話すこともできるため、非常に自然な対話が可能となっています。

まとめ

OpenAIのSpring Updateでは、GPT-4oをはじめとする新機能の発表が行われました。GPT-4oは、GPT-4よりも高速で、テキスト、視覚、音声の一括処理が可能となっています。また、無料ユーザーにも提供されます。デスクトップ版ChatGPTの提供開始やUIの刷新など、さまざまな新機能が発表されました。今後もOpenAIの動向に注目です。

参考

おすすめアイテム

※このリンクを経由して商品を購入すると、当サイトの運営者が報酬を得ることがあります。詳細はこちら。

このサイトを支援する

Buy Me a CoffeeまたはGitHub Sponsorsで支援していただけると、サイトの運営やコンテンツ制作の励みになります。定期的な支援と一度限りの支援がありますので、お間違いのないようにお願いします。

-1.png&w=256&q=75)

生まれた時から、母国語よりも先にJavaScriptを使っていました。ネットの海のどこにもいなくてどこにでもいます。

Webフロントエンドプログラマーで、テクノロジーに関する話題を追いかけています。動画編集やプログラミングが趣味で、たまにデザインなどもやっています。主にTypeScriptを使用したWebフロントエンド開発を専門とし、便利で実用的なブラウザー拡張機能を作成しています。また、個人ブログを通じて、IT関連のニュースやハウツー、技術的なプログラミング情報を発信しています。